位置情報を常に発信・受信するスマートフォンの普及に伴って、最近では位置情報を用いたゲーム(いわゆる位置ゲー)や、コロナウイルス感染症の拡大防止のための接触確認アプリ(COCOA:現在は機能停止)といった形で、スマホが携帯型コンピュータ端末であることを前提としたアプリが活用されるようになってきました。

このような携帯端末の究極形は、いわゆるウェアラブル端末といわれる「身につけるコンピュータ」ですが、その中でもARグラス(拡張現実グラス)はコンピュータのモニターを透かして現実世界を観るということで、仮想現実技術が発展するとともに、その活用方法の研究開発が広く行われています。

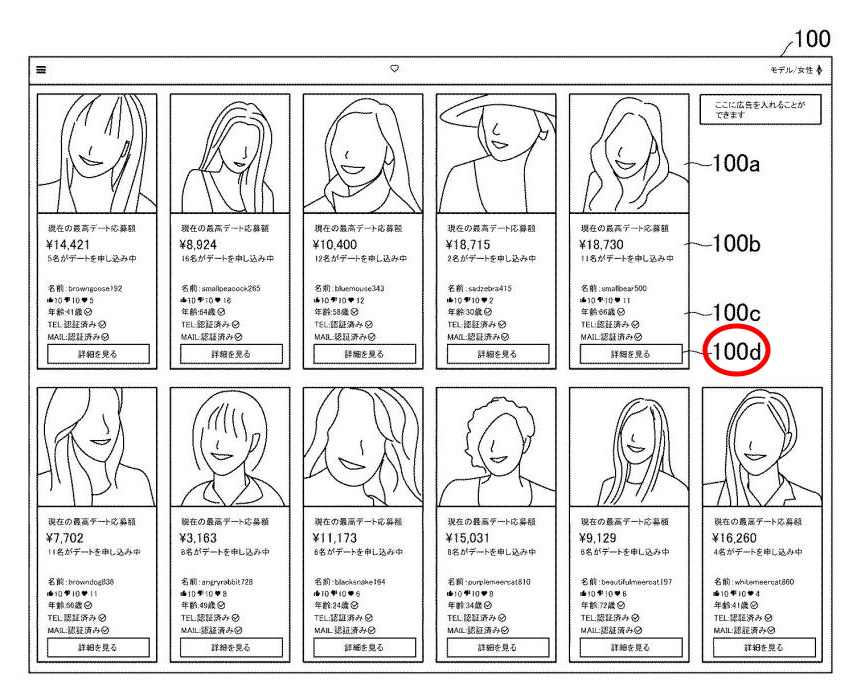

今回紹介する特許は、ARグラスを用いたリアルタイムのマッチングサービスに関し、街を歩いて自動的に好みの相手を探し出すというものです(もちろん、相手に声をかけることができるかはユーザーの「コミュ力」によります)。どのような技術・観点で「好みの相手」を抽出するのか、特許発明の詳細について、解説していきます。

発明の背景

ソフトバンクは、ウェアラブルコンピューティングの関連機器と、その利用方法に関する研究開発を続けていて、カメラを内蔵した眼鏡型デバイスによって、ユーザーが注視している人物を特定して、その人物に関連する情報を表示する技術(特開2012-008290)を開示しています。

この技術は、あくまでも注視している対象人物を、サーバと連携して精度良く特定することができる技術を開示したものであり、その応用範囲を具体的に特定するものではありませんでした。

どんな発明?

発明の目的

本発明は、マッチングシステム、眼鏡型デバイス、マッチングサーバ及びプログラムに関するものです。AR(Augmented Reality:拡張現実)グラス等の眼鏡型デバイスは、今後普及が進み、眼鏡型デバイスによって、装着者の視線データ、つまり何を見ているかという情報が取得可能になります。

例えば、通り過ぎた人の中でどのような人に着目したかがわかるようになります。本発明は、このような情報が取得できるという技術を前提として、その情報をもとにしたマッチングサービスを提供しようというものです。

発明の詳細

では、図・画像を一部参照しながら、本発明の詳細を説明していきます。

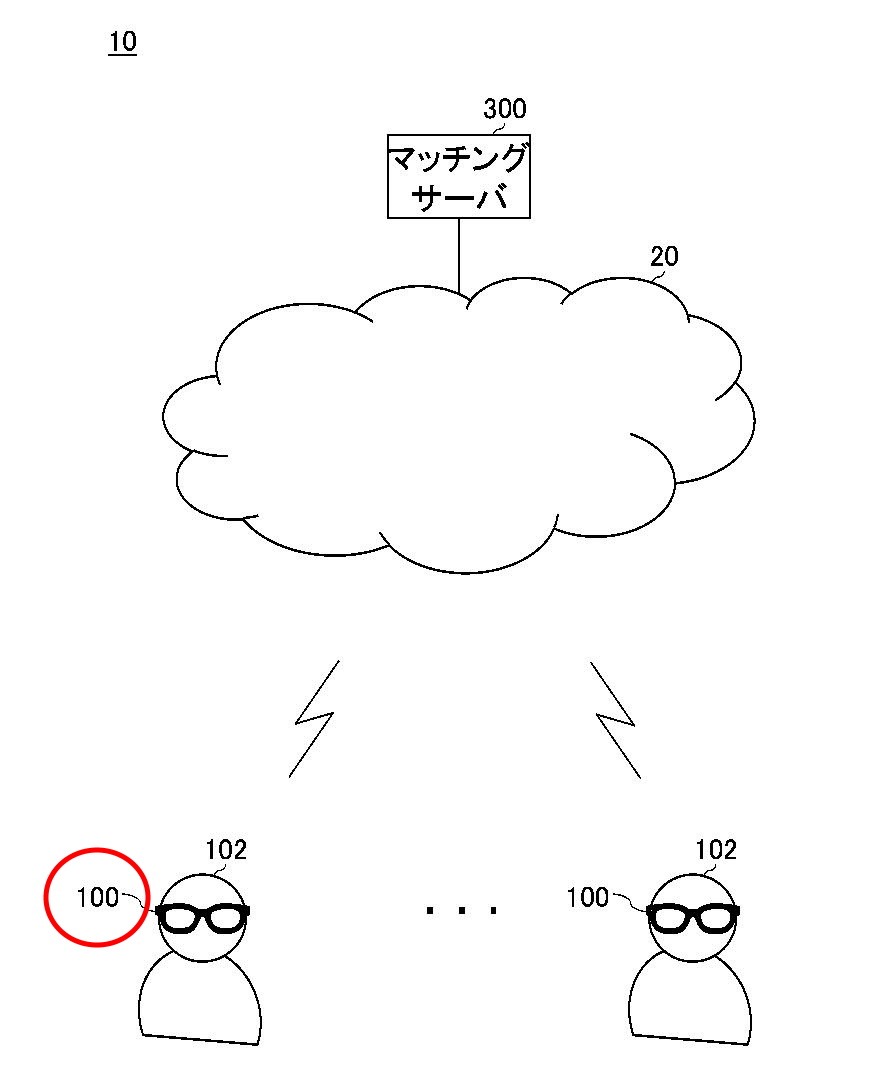

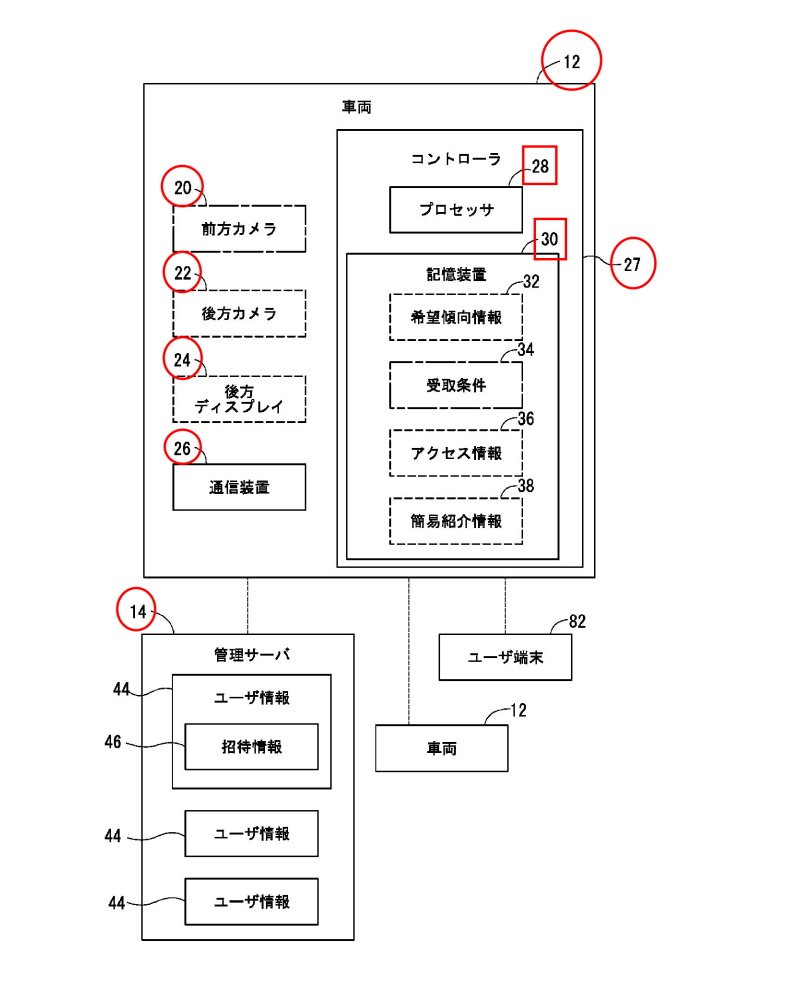

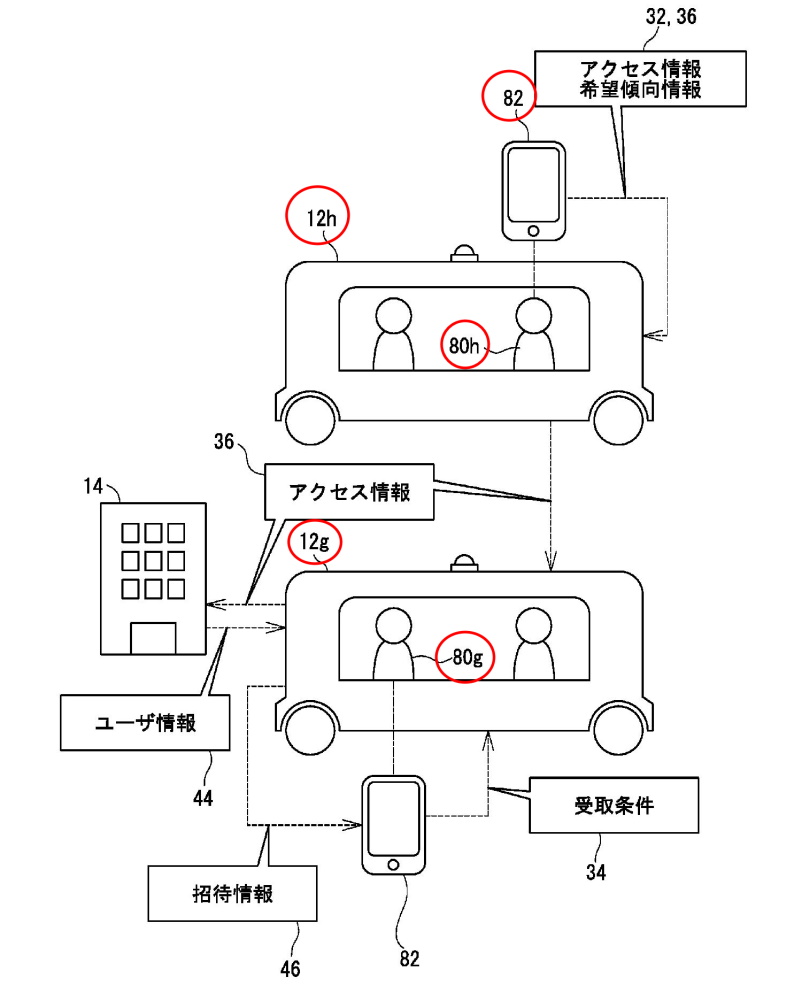

まず、図1は、マッチングシステム10の一例を概略的に示したものです。マッチングシステムは、複数の眼鏡型デバイス100とマッチングサーバ300を備えます。

【図1】

【図1】

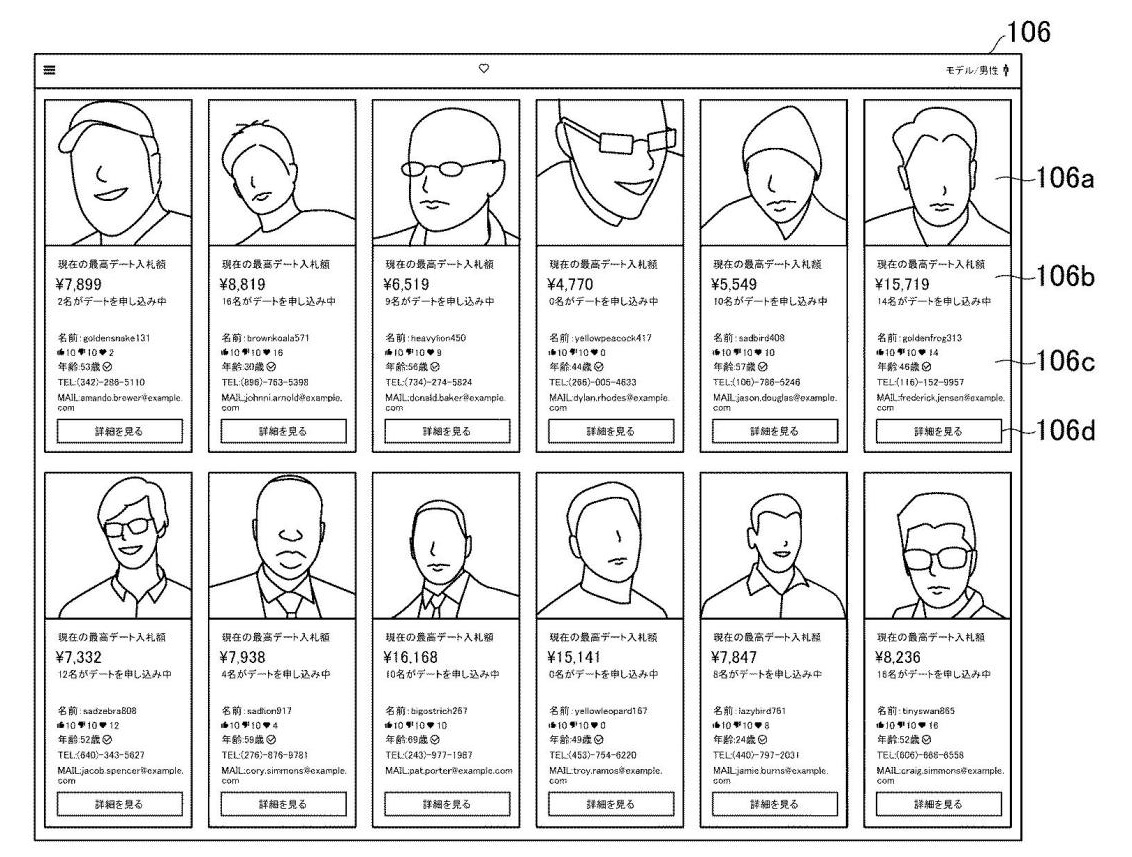

眼鏡型デバイス100は、いわゆるARグラスです。撮像範囲に合わせたコンテンツを、透明又は半透明のグラス上に表示することによって、実空間にコンテンツが配置されているような感覚をユーザ102に与えることが可能なデバイスです。

マッチングサーバ300は、ユーザ102に対してマッチングサービスを提供します。マッチングサービスとは、恋人や結婚相手等を見つけることを支援するサービスです。マッチングサーバ300は、ユーザ102に対して、当該ユーザの好みの顔の特徴を持った人物を紹介したり、当該ユーザの顔の特徴が好みである相手を紹介したり、互いに好みが一致した相手を紹介したりするサービスを提供します。

【図2】

【図2】

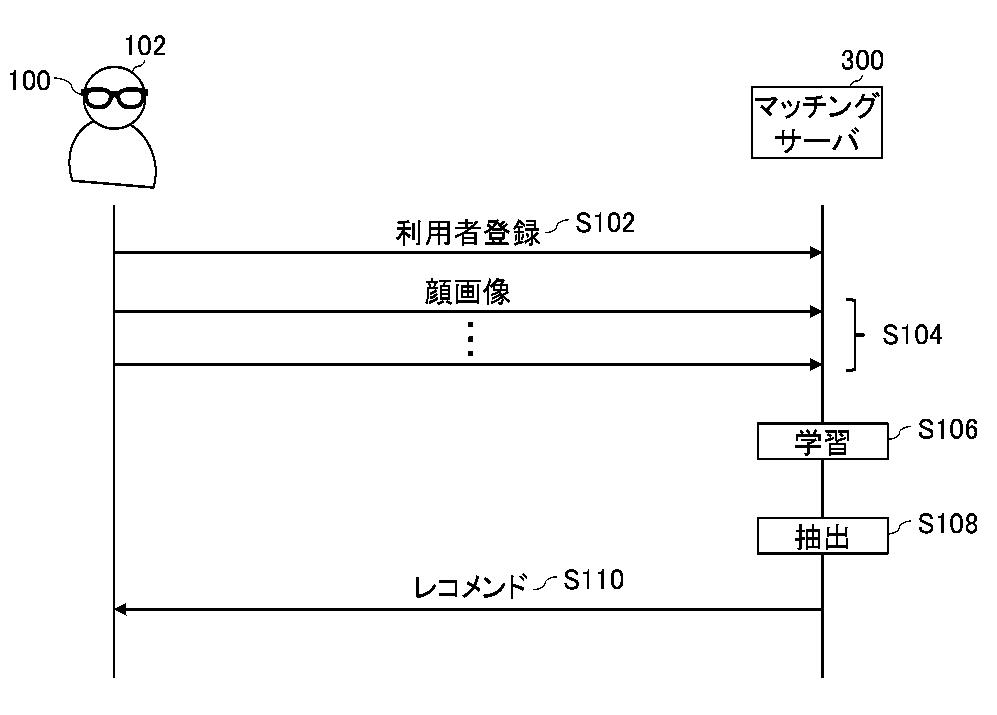

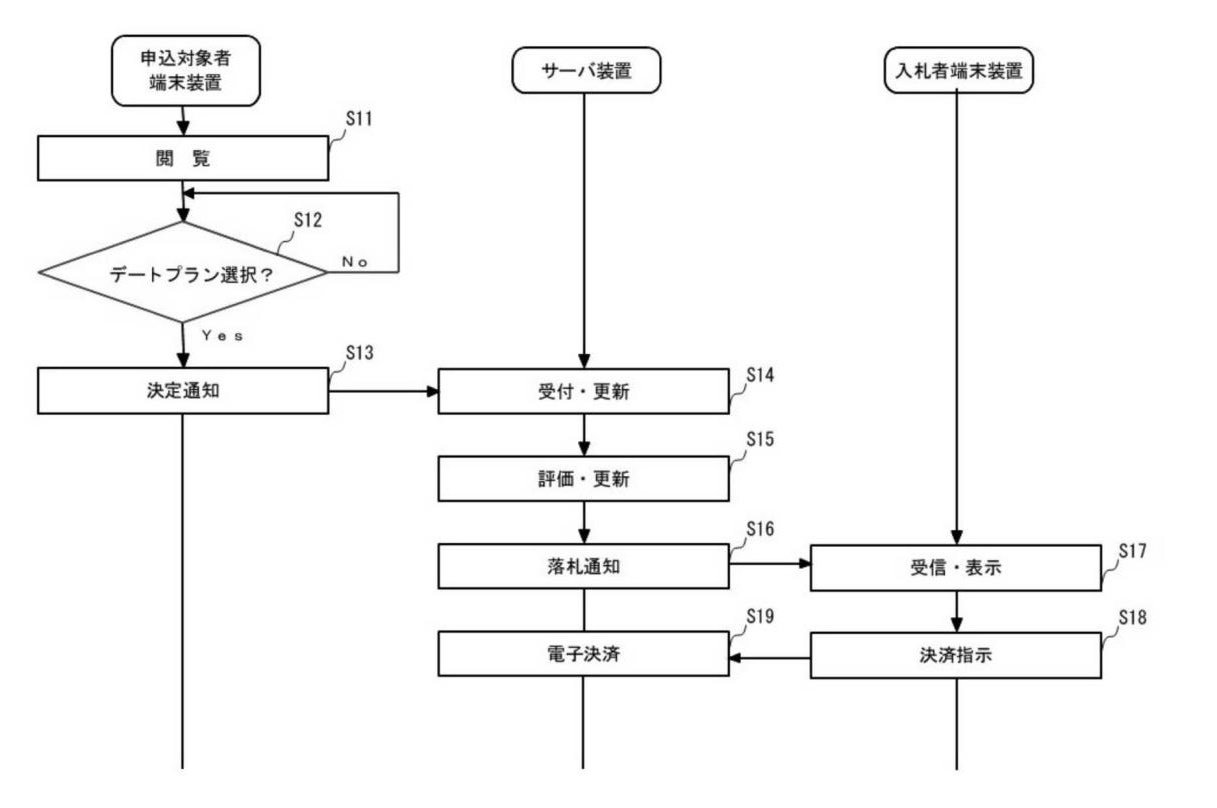

図2は、マッチングシステム10における処理の流れの一例を概略的に示したものです。ここでは、ユーザ102が、マッチングサーバ300のマッチングサービスに登録して、ユーザ102の好みにあった他のサービス登録者の「レコメンド」を受けるまでの流れを概略的に示します。

ステップ(以下、ステップをSと省略して記載します)102では、ユーザ102が、眼鏡型デバイス100によって、マッチングサーバ300に利用者登録を行います。眼鏡型デバイス100は、ユーザ102の指示に従って、ユーザ102の登録者情報をマッチングサーバ300に送信します(もちろん、ユーザは眼鏡型デバイス経由だけでなく、スマホやPCから利用者登録を行ってもよい)。

S104では、ユーザ102が日常生活を送っている間に、眼鏡型デバイス100が、ユーザ102が注目した人物の顔画像をマッチングサーバ300に送信していきます。眼鏡型デバイス100は、眼鏡型デバイス100のカメラによって撮像された撮像画像から、ユーザ102が注目した人物の顔画像を取得して、マッチングサーバ300に送信していくのです。

S106では、マッチングサーバ300が、ユーザ102の眼鏡型デバイス100から受信した複数の顔画像に基づいて、ユーザ102の好みの顔の特徴を学習します。S108では、マッチングサーバ300が、S106において学習した学習データに基づいて、複数のサービス登録者から、ユーザ102の好みの顔の特徴を有するサービス登録者を抽出します。

【図3】

【図3】

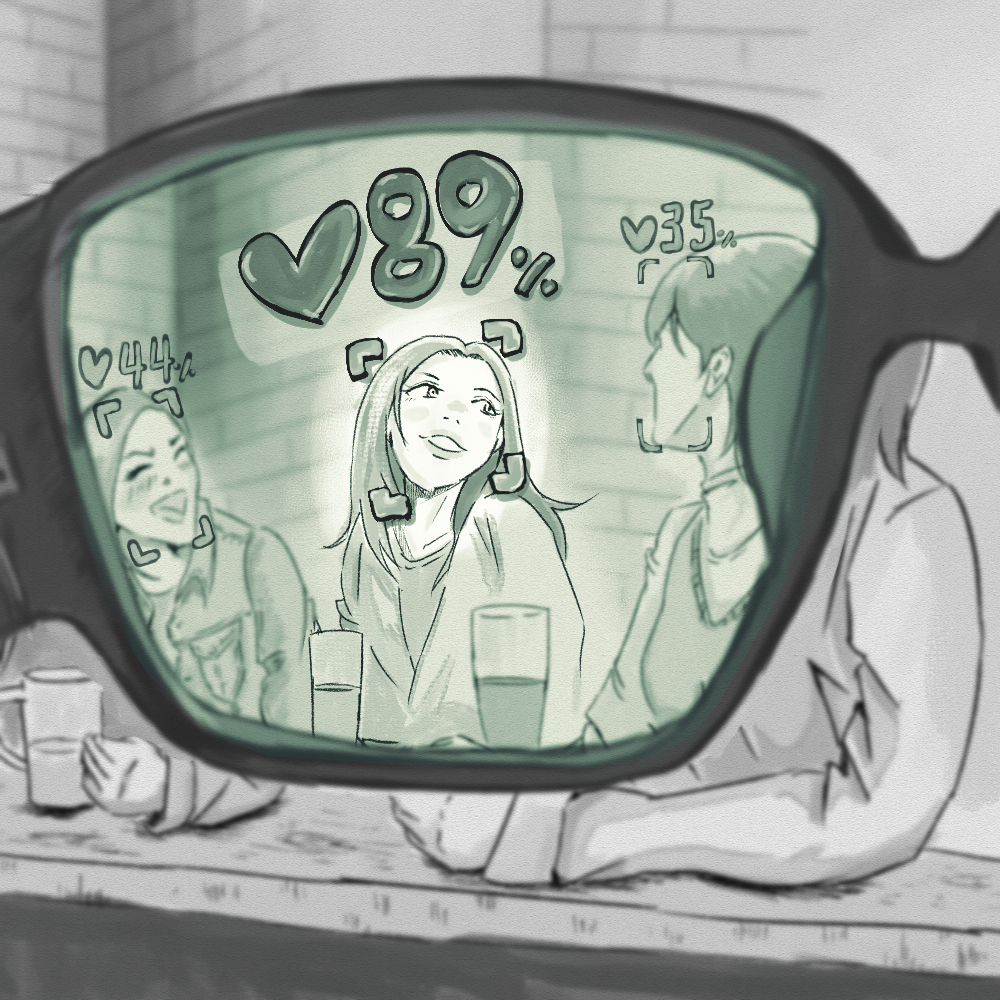

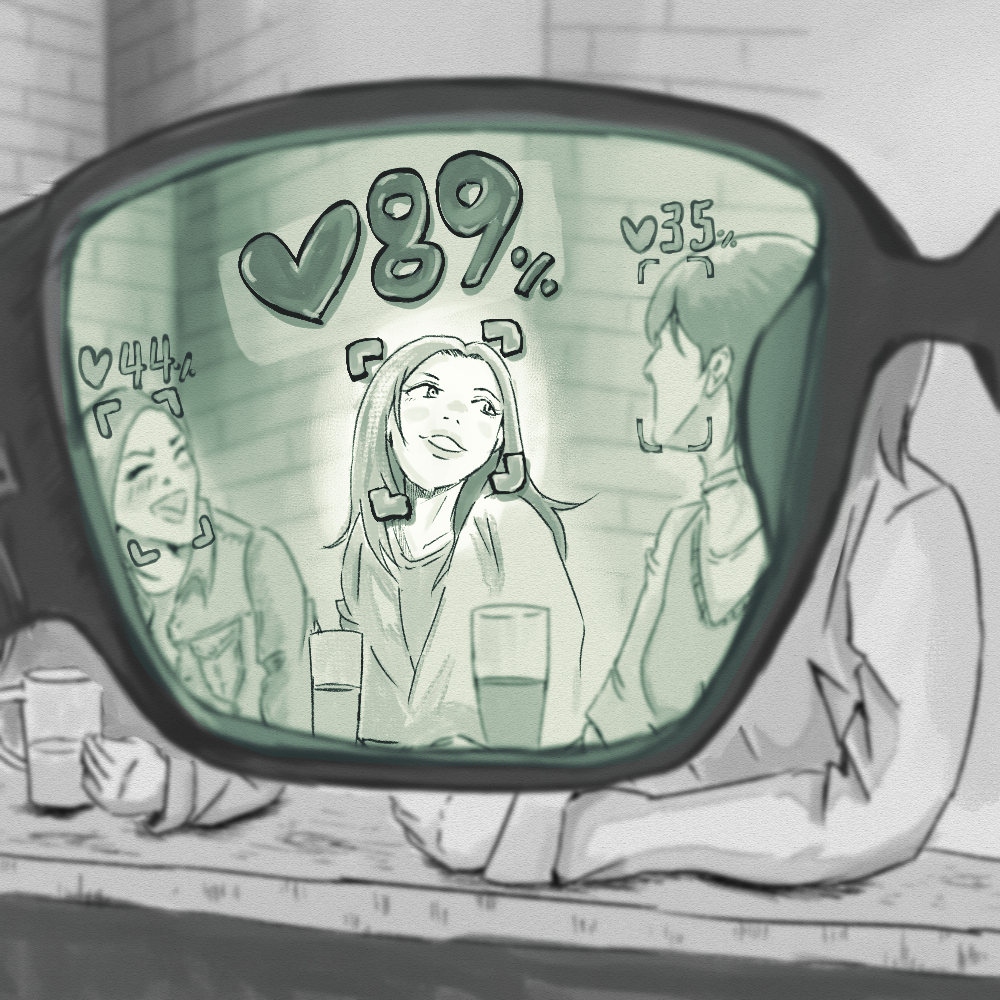

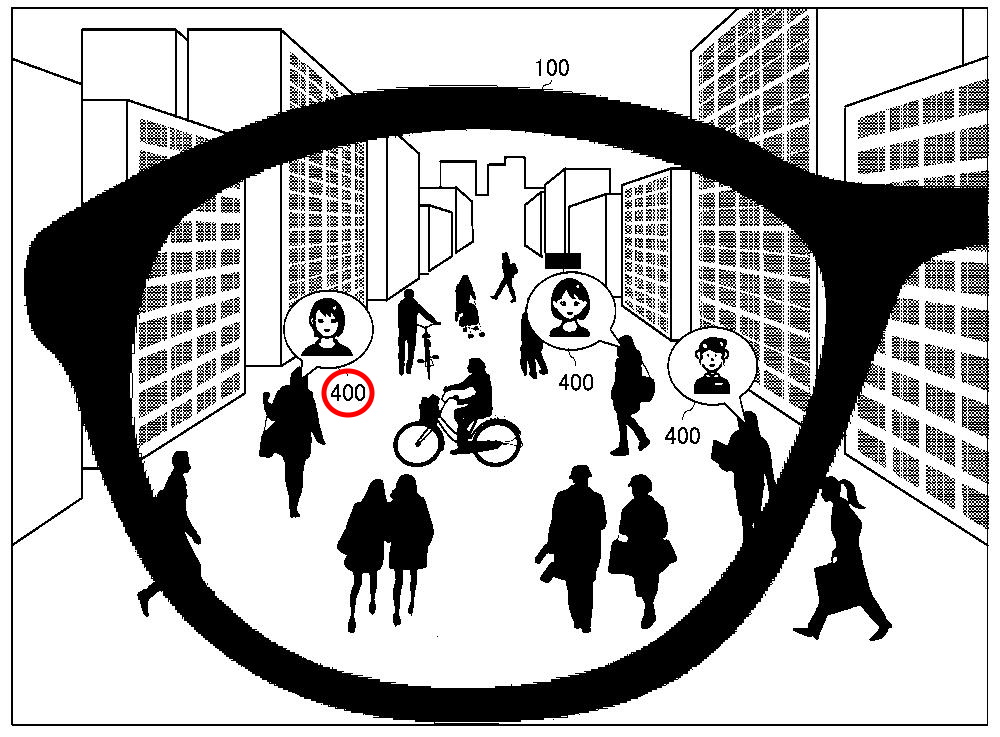

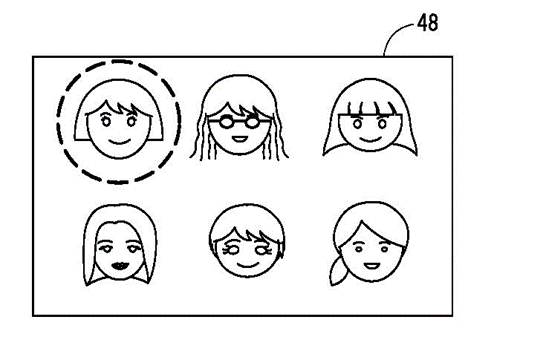

図3は、眼鏡型デバイス100による顔特定処理について説明するための説明図です。眼鏡型デバイス100は、ユーザ102の視線に基づいて、ユーザ102が注目した顔を特定していきます。

例えば、ユーザ102の視線が向けられた人物に対応するレンズ上の位置に、人物のアイコン400を表示します。

ここから、ユーザ102が「本当に注目した顔」であると決定するにあたっては、いくつかの態様が考えられます。例えば手動登録の態様としては以下の2つの例が挙げられます。手動登録とすることによって、マッチングサーバ300は、ユーザ102の好みの顔の顔画像を高い精度で収集することができます。

①ユーザ102によってアイコン400が指定された場合に、指定されたアイコン400に対応する顔を、ユーザ102が注目した顔として特定する。

②アイコン400に「いいねボタン」を含め、ユーザ102によっていいねボタンが指定されたことに応じて、ユーザ102が注目した顔として特定する。

これに対して、眼鏡型デバイス100は、ユーザ102が注目した顔を自動登録する態様も考えられます。

③ユーザ102が視線を向けた回数に基づいて、ユーザ102が注目した顔を特定する。例えば、ユーザ102の視線が向けられた回数が予め定められた回数よりも多い顔を、ユーザ102が注目した顔として特定する。

④ユーザ102が視線を向けた時間に基づいて、ユーザ102が注目した顔を特定する。例えば、ユーザ102の視線が向けられた時間が予め定められた時間よりも長い顔を、ユーザ102が注目した顔として特定する。

自動登録とすることによって、ユーザ102に負荷をかけることなく、マッチングサーバ300が、ユーザ102の好みである可能性が高い顔の顔画像を収集することができます。

【図4】

【図4】

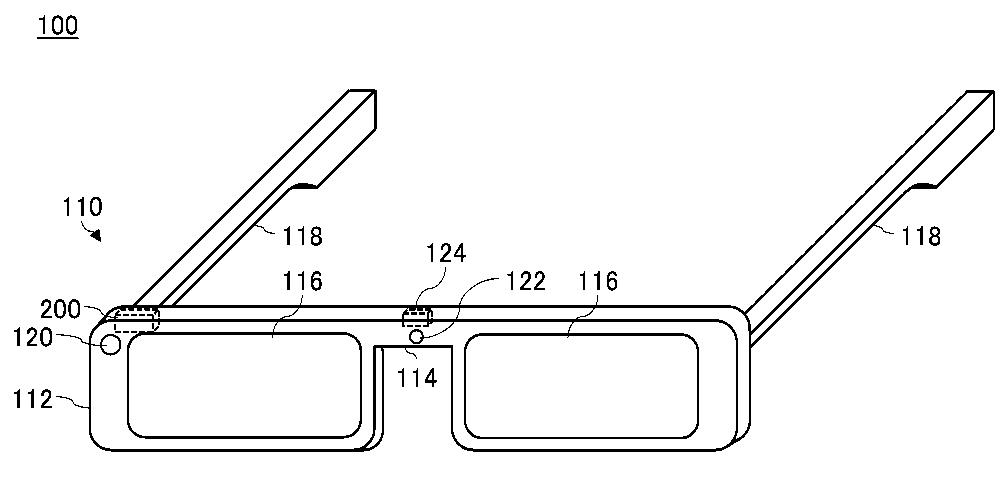

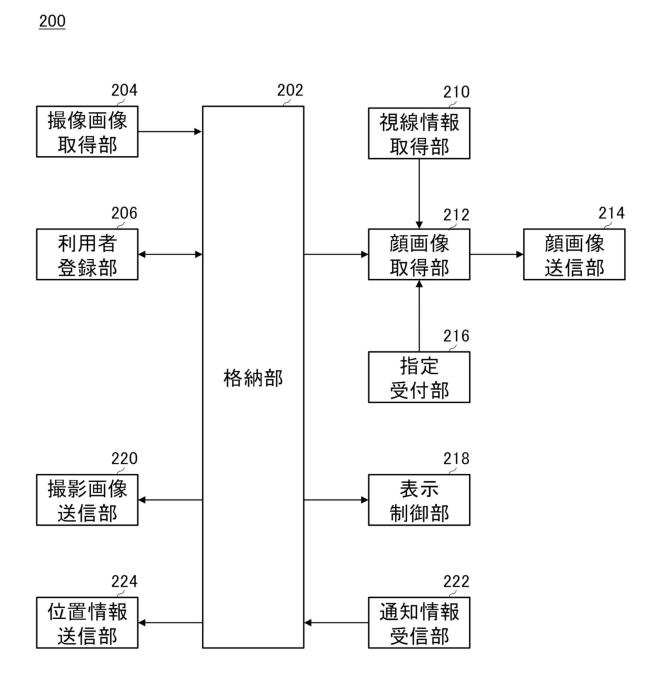

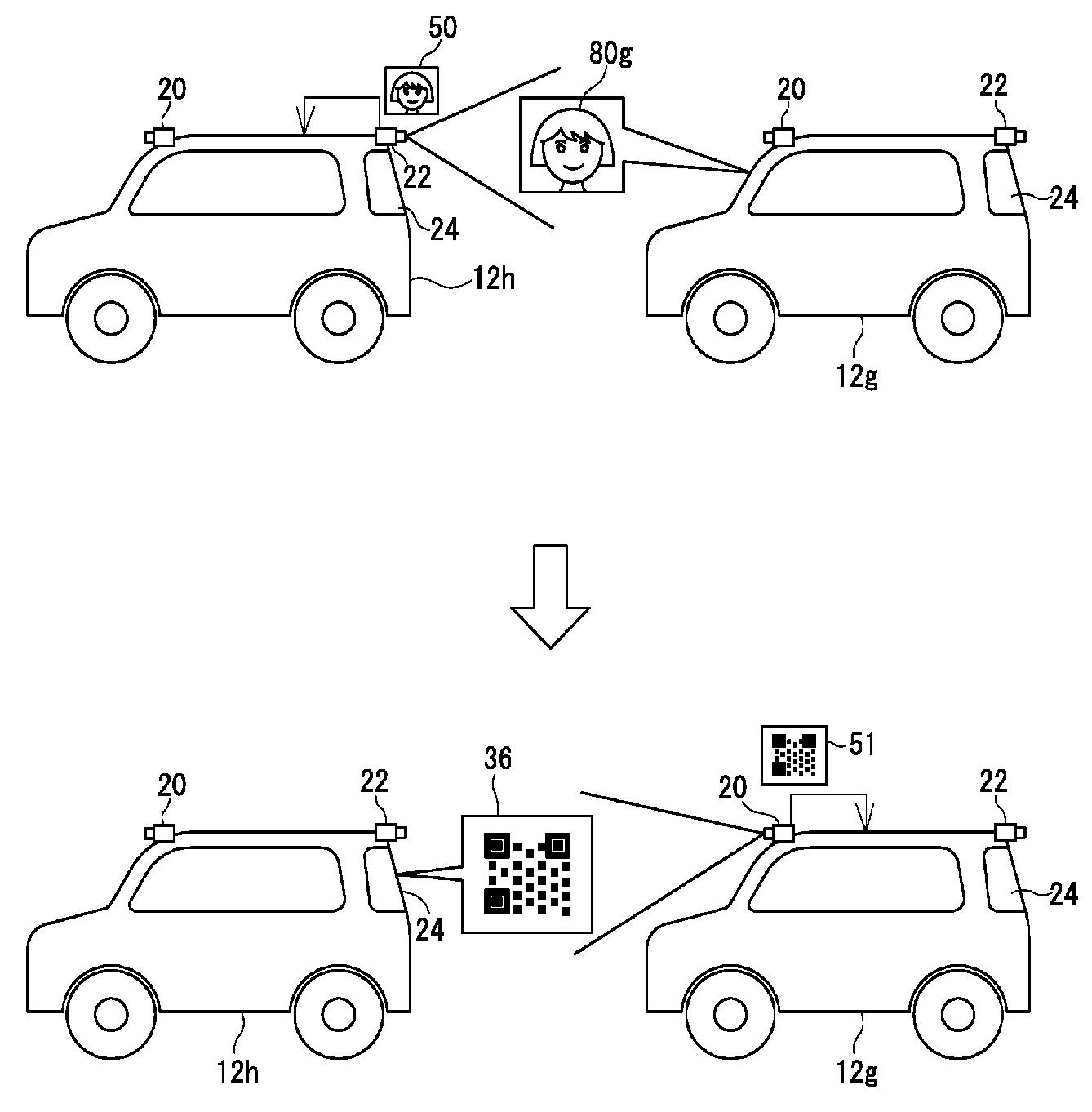

上述のようなARグラスの例示としては、図4のようなデバイスが考えられます。カメラ120、センサ122、視線検出部124、制御装置200などを備えます。センサ122は周囲の環境を特定するために必要なものです。視線検出部124はユーザの目を常に撮像してその視線を検出します。制御装置200は例えばGPSやジャイロセンサなどによって眼鏡型デバイスの位置や向き、姿勢を特定するセンサをはじめ、ネットワークを介した通信を行ったりする中核的な機能を有するものです。図5に、制御装置200の機能構成を例示します。

【図5】

【図5】

撮像画像取得部204は、カメラ120によって撮像された撮像画像を取得し、格納部202に格納(保存)します。

利用者登録部206は、ユーザ102の指示に従って、マッチングサーバ300に対して利用者登録を行います。

視線情報取得部210は、ユーザ102の視線を示す視線情報を、視線検出部124から取得します。

顔画像取得部212は、ユーザ102の視線に基づいて、カメラ120によって撮像された撮像画像から顔画像を取得します。

顔画像送信部214は、顔画像取得部212によって取得された顔画像をマッチングサーバ300に送信します。

指定受付部216は、ユーザ102による、撮像画像取得部204が取得した撮像画像内の顔の指定を受け付けます。

表示制御部218は、通知情報受信部222が通知情報を受信した場合に、レンズ116に通知アイコンを表示します。

撮像画像送信部220は、撮像画像取得部204によって撮像される撮像画像を継続的にマッチングサーバ300に送信します。マッチングサーバ300は、眼鏡型デバイス100から継続的に受信する撮像画像を解析して、ユーザ102の好みの顔の特徴を有すると推定したサービス登録者が含まれるか否かを判定します。そして、含まれると判定した場合に、眼鏡型デバイス100に対して通知情報を送信します。

通知情報受信部222は、マッチングサーバ300から通知情報を受信します。

位置情報送信部224は、眼鏡型デバイス100の位置情報をマッチングサーバ300に送信します。予め定められたタイミングに従って、眼鏡型デバイス100の位置情報をマッチングサーバ300に送信します。

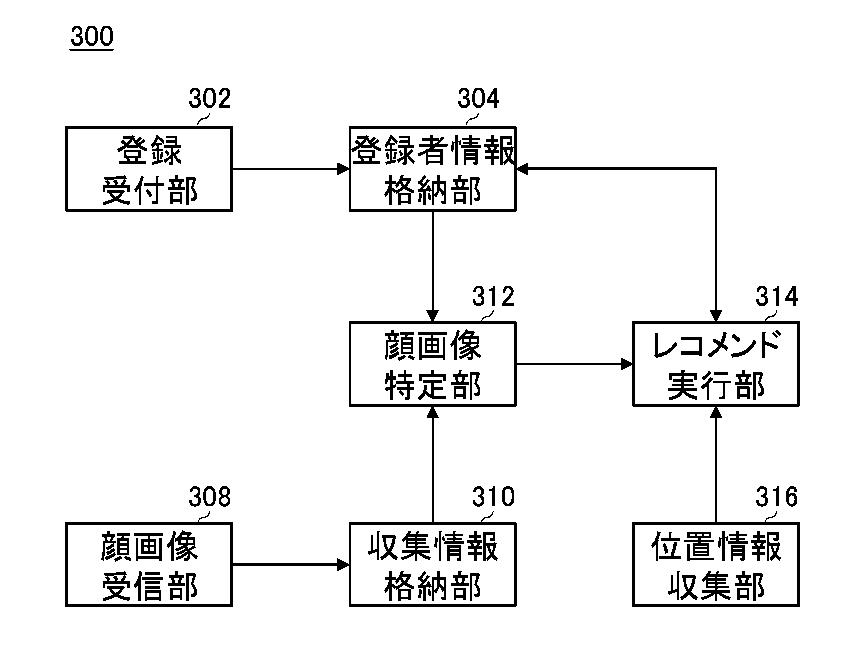

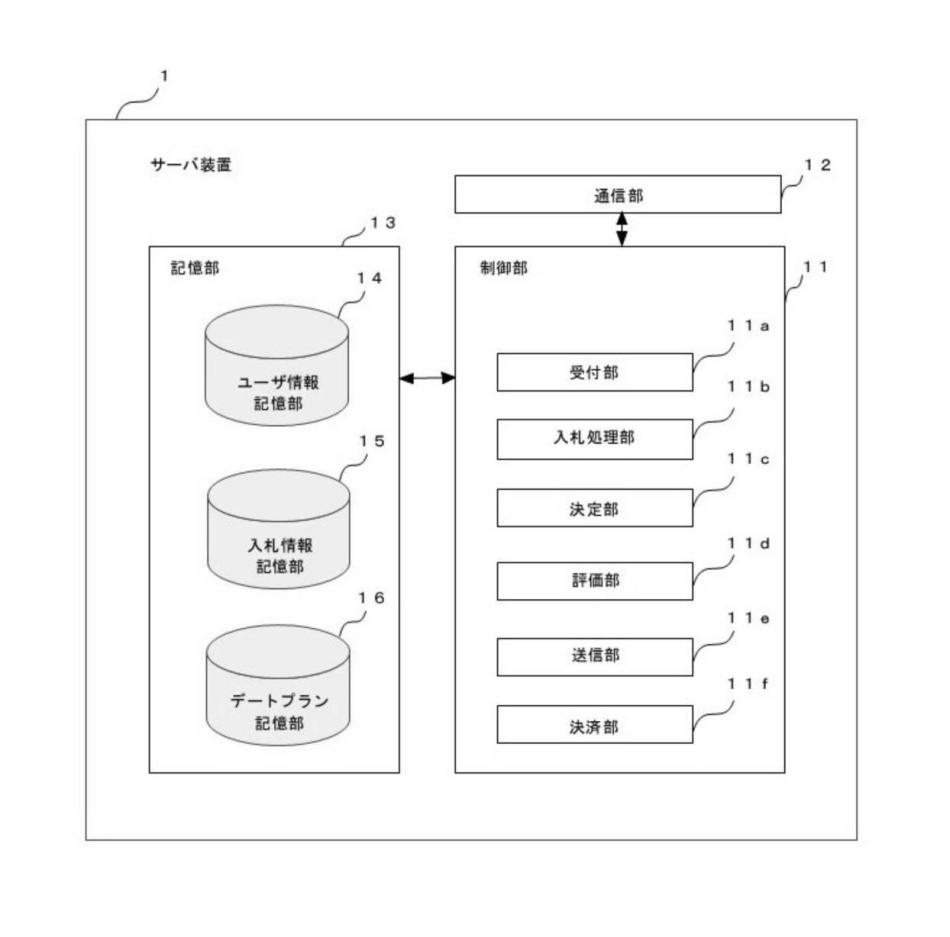

マッチングサーバ300に関する機能構成の一例は、図6に示されます。

【図6】

【図6】

登録受付部302は、ユーザ102による、マッチングサービスに対する登録を受け付けます。

登録者情報格納部304は、登録受付部302が受信した登録者情報を格納します。

顔画像受信部308は、複数のユーザ102のそれぞれの眼鏡型デバイス100から、顔画像取得部212が、ユーザ102の視線に基づいて取得した顔画像を受信します。

収集情報格納部310は、顔画像受信部308が眼鏡型デバイス100から受信した顔画像を、当該眼鏡型デバイス100のユーザ102に対応付けて格納します。

顔画像特定部312は、登録者情報格納部304に格納されている複数の顔画像から、収集情報格納部310に格納されている一のユーザ102に対応する複数の顔画像に類似する顔画像を特定します。例えば、収集情報格納部310に格納されている一のユーザ102に対応する複数の顔画像に基づいて、当該一のユーザ102の好みの顔の特徴を学習し、学習データに基づいて、登録者情報格納部304に格納されている複数の顔画像から当該一のユーザ102に対応する複数の顔画像に類似する顔画像を特定します。

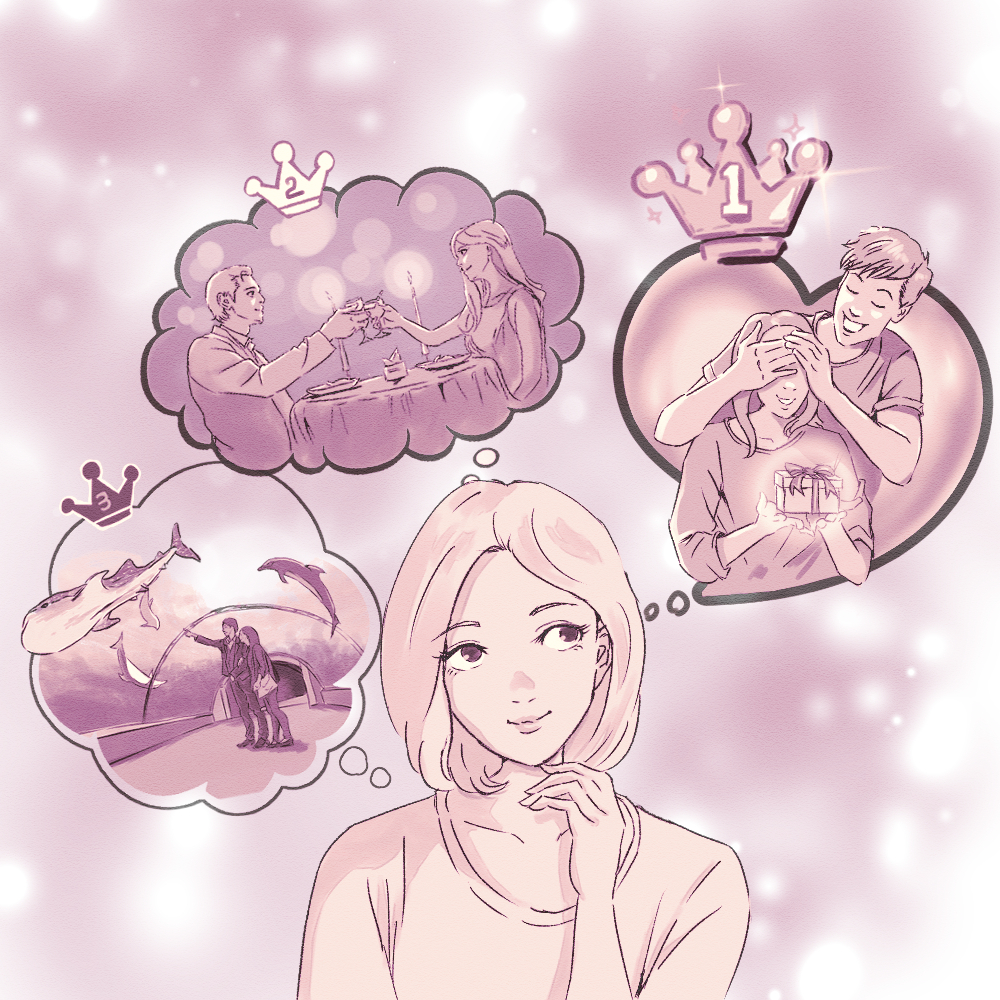

レコメンド実行部314は、顔画像特定部312によって特定された顔画像に基づいて、ユーザ102に対する他のサービス登録者のレコメンドを実行します。例えば、顔画像特定部312によって特定された顔画像に対応するサービス登録者を、ユーザ102が好みの相手として、レコメンドします。

また、例えば、顔画像特定部312が特定した、収集情報格納部310に格納されている他のサービス登録者に対応する複数の顔画像に類似する顔画像に、ユーザ102の顔画像が含まれる他のサービス登録者を、ユーザ102の顔を好みとする相手として、ユーザ102にレコメンドすることも考えられます。これにより、ユーザ102は、複数のサービス登録者のうち、自分の顔を好みとする可能性が高いサービス登録者を知ることができます。このように、本実施形態に係るマッチングシステム10によれば、自分を好みとする相手を探すことに貢献でき、マッチングが成立する可能性を高めることができるのです。

なお、サービス登録者であることを、外部に公開するか否かは、当該サービス登録者の設定に応じて変更可能です。例えば、登録受付部302は、ユーザ102による、サービス登録者であることを外部に公開するか否かの設定を受け付けます。ユーザ102は、例えば、自分の状況に応じて、適宜、設定を変更し得ます。レコメンド実行部314は、第1のユーザ102に対してレコメンドする対象となる第2のユーザ102の当該設定に基づいて、第1のユーザ102への第2ユーザ102のレコメンドを実行するか否かを判定します。

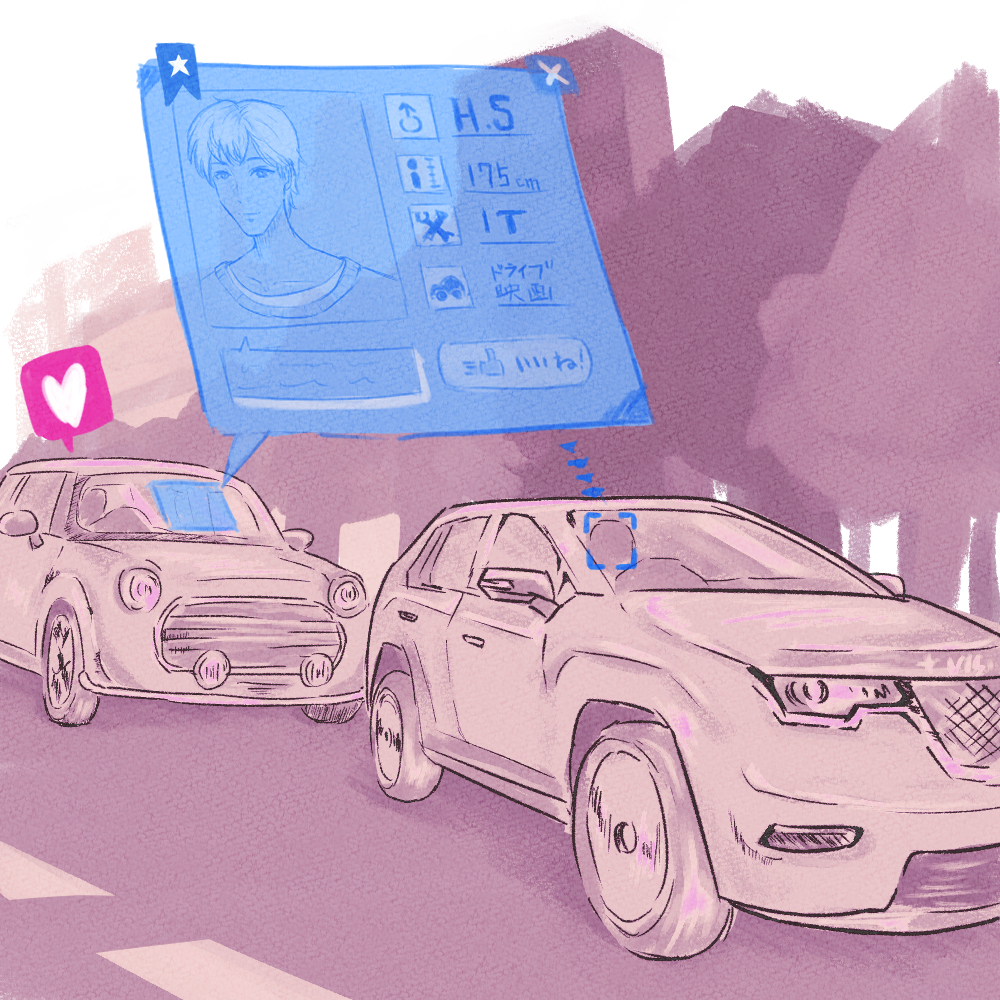

具体的には、レコメンド実行部314は、一のユーザ102が装着している眼鏡型デバイス100の撮像範囲内に、顔画像特定部312によって特定された一のユーザ102に対応する複数の顔画像に類似する顔画像に対応する他のサービス登録者が含まれる場合に、当該サービス登録者の設定を確認します。

そして、サービス登録者であることを外部に公開するよう設定されている場合には、当該他のサービス登録者を一のユーザ102にレコメンドし、サービス登録者であることを外部に公開しないよう設定されている場合には、レコメンドを行いません。これにより、例えば、街中で急いでいるとき等、声をかけられたくない状況のときに、急に声をかけられてしまうことを防止することができ、ユーザ102の利便性を向上することができます。

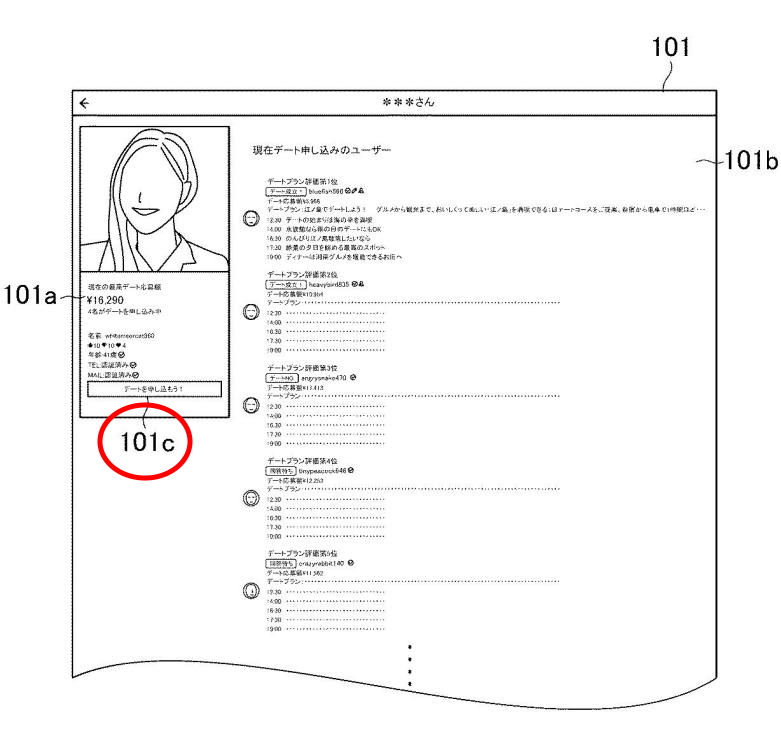

【図7】

【図7】

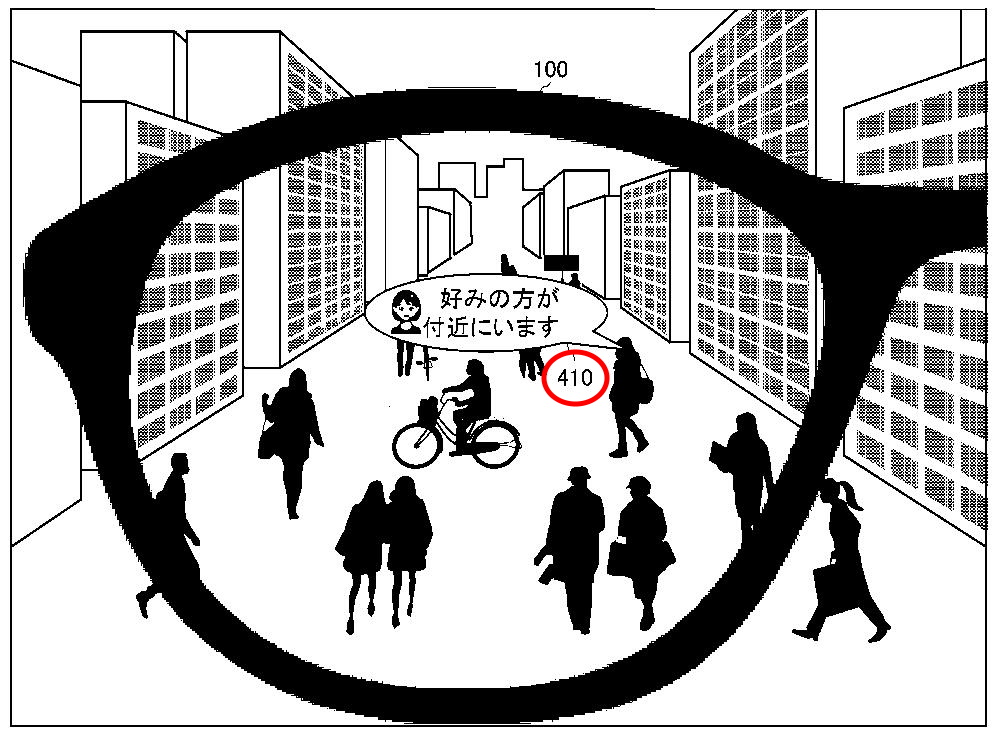

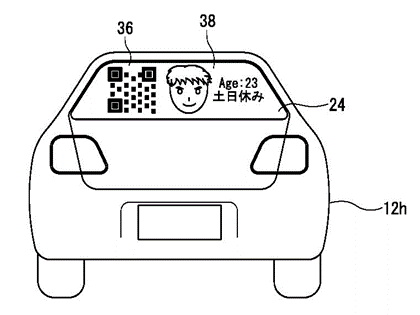

図7は、眼鏡型デバイス100による通知アイコン410の表示例を概略的に示したものです。眼鏡型デバイス100は、カメラ120の撮像範囲内に、ユーザ102が好みとする顔の特徴を有すると推定したサービス登録者が含まれる条件が満たされたことに応じ、マッチングサーバ300が送信した通知情報に基づいて、通知アイコン410をレンズ116に表示します。通知アイコン410は、図7に示すように、「好みの方が付近にいます」等のメッセージを含みます。これにより、ユーザ102は、サービス登録者であって、自分が好みとする顔の特徴を有する人物を認識することができます。このようなマッチングシステム10によれば、出会いの機会を増加させることが可能です。

【図8】

【図8】

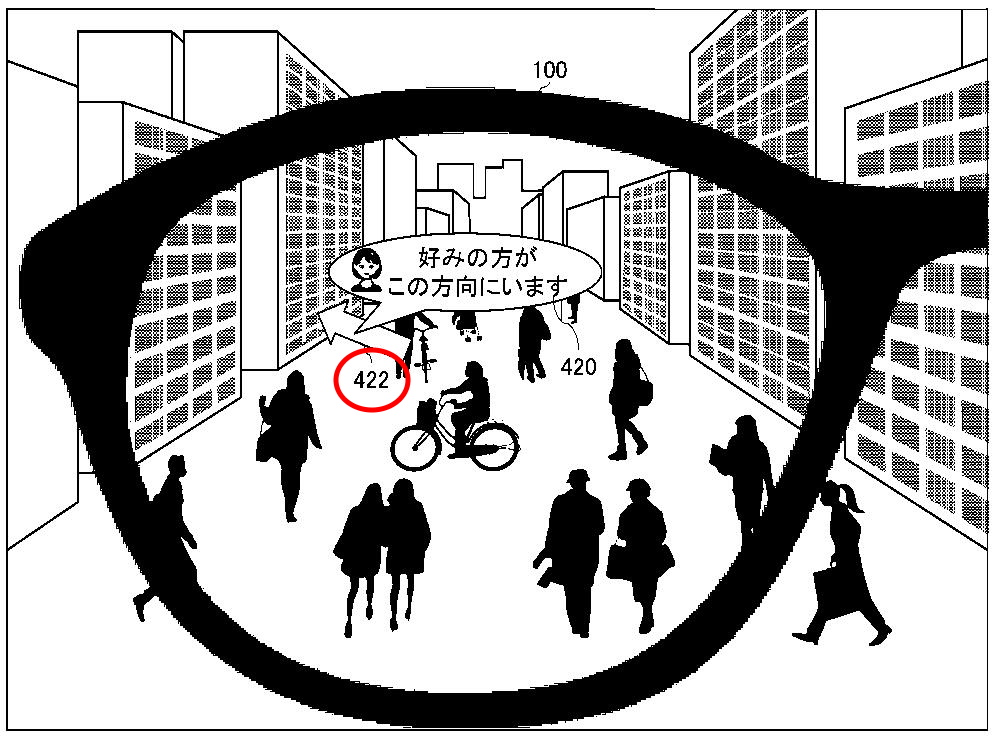

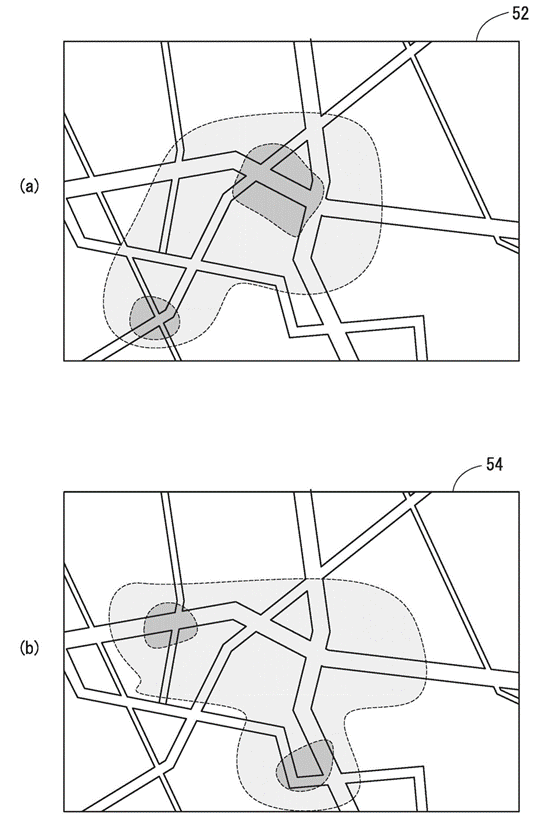

眼鏡型デバイス100による通知のさらなる例として図8が示されます。眼鏡型デバイス100は、眼鏡型デバイス100の位置から予め定められた範囲内に、ユーザ102が好みとする顔の特徴を有すると推定したサービス登録者が含まれる条件が満たされたことに応じてマッチングサーバ300が送信した通知情報に基づいて、通知アイコン420をレンズ116に表示します。通知アイコン420は、対象となるサービス登録者が位置する方向を示す方向オブジェクト422を含みます。これにより、ユーザ102は、サービス登録者であって、自分が好みとする顔の特徴を有する人物がいる方向を認識することができます。このように、本実施形態に係るマッチングシステム10によれば、出会いの機会を増加させることができるのです。

さて、ここまで、好みである可能性の高い相手をレコメンドするまでの仕組みを説明してきましたが、レコメンド後、レコメンド実行部314は、ユーザ102に対して他のサービス登録者をレコメンドした後に、ユーザ102と他のサービス登録者とのマッチングが成立したか否かを特定します。

例えば、眼鏡型デバイス100は、レコメンドされた相手とマッチングしたことを送信するUI(User Interface)を表示する。そして、眼鏡型デバイス100は、UIに対するユーザ102の指定を受け付けた(つまり、ユーザ102が手動でマッチングしたことを入力した)ことに応じて、ユーザ102と他のサービス登録者とがマッチングしたことを通知する通知情報をマッチングサーバ300に送信します。

逆に、UIに対するユーザ102の指定を受け付けないまま一定時間が経過し、タイムアウトした場合に、マッチングが成立しなかったことを示す通知情報をマッチングサーバ300に送信します。眼鏡型デバイス100は、レコメンドされた相手とマッチングしたこと、又はしなかったことを送信するUIを表示します。

なお、眼鏡型デバイス100が、ユーザ102と他のサービス登録者とのマッチングが成立したか否かを自動的に判定する態様も考えられます。例えば、レコメンドされた他のサービス登録者が、ユーザ102の視界に映る時間が予め定められた時間よりも長かったり、ユーザ102と他のサービス登録者との距離が予め定められた距離よりも短い状態が予め定められた時間以上継続したりした場合に、ユーザ102と他のサービス登録者とがマッチングしたとみなします。

そして、レコメンド実行部314は、マッチングが成立している状態である場合には、レコメンドを一時的に停止します。

これにより、レコメンドによってマッチングし、ユーザ102と他のサービス登録者とが食事等を一緒にした場合に、食事中に「好みの方が付近にいます」というレコメンドを受けてしまったり、マッチングしているにも関わらず、自身のことを好みであるという相手に通知が行ってしまったりすることを防止できます。

なお、顔画像送信部214は、顔画像取得部212が取得した顔画像のうち、除外対象の顔を設定することができます。除外の対象となる人物の顔画像である場合、マッチングサーバ300に送信しないように構成されます。これにより、好みの顔かどうかにはかかわらず、日常的によく見る家族、友人、及び同僚等の顔が好みの顔として登録されてしまうことを防止できます。

ここがポイント!

本発明は、ARグラス等の眼鏡型デバイスによって、装着者の視線データを取得することによって、ユーザがどのような人に着目したか、逆にどのような人がユーザを着目しているのかというデータを取得し、そのデータに基づいてマッチングを図るシステムです。視線データを解析し、どのような観点・閾値に基づいて「好みの顔」だと認定するかが本発明の技術的ポイントといえるでしょう。

ただ、好みの相手というのは顔だけで決まるものではないことは、一般的に知られたことですので、単に顔を注視したことをもって「好み」とするかどうかは、今後本発明の技術が実用化がされる場合には、議論が分かれるところかもしれません。

未来予想

ARグラス自体はすでに実用可能なデバイスとして、我々もそのガジェットとしての機能・構成は広く理解されていると思われます(現実に広く普及しているかどうかは別として)。しかし、その利用方法については、やはりすでに我々が活用しているモニターに投影する様々な技術、例えばナビゲーションシステムであったり動画等の視聴などは容易に思いつくものの、本発明のようなリアルタイムのマッチング技術というのはなかなか新しい活用方法だと感じます。

現実的には実用化にあたって種々のモラル的な問題をはらんでいるようにも思えますが、技術的には今後のさらなる応用が期待できますね。

特許の概要

|

発明の名称 |

マッチングシステム、眼鏡型デバイス、マッチングサーバ及びプログラム |

|

出願番号 |

特願2020-197558 |

|

公開番号 |

特開2022-085730 |

|

特許番号 |

特許第7187523号 |

|

出願日 |

2020.11.27 |

|

公開日 |

2022.6.8 |

|

登録日 |

2022.12.2 |

|

審査請求日 |

2021.2.18 |

|

出願人 |

ソフトバンク株式会社 |

|

発明者 |

石垣健太 他 |

| 国際特許分類 |

G06Q 50/10 (2012.01) |

|

経過情報 |

・当初出願した発明のうち、一部の請求項に新規性なしの拒絶理由通知がされたが、補正により拒絶理由のない請求項に限定し、特許となった。 |

【図1】

【図1】 【図2】

【図2】 【図3】

【図3】 【図4】

【図4】 【図5】

【図5】 【図9】

【図9】 【図10】

【図10】 【図1】

【図1】 【図2】

【図2】 【図4】

【図4】 【図5】

【図5】 【図6】

【図6】 【図7】

【図7】 【図8】

【図8】 【図9】

【図9】 【図10】

【図10】 【図11】

【図11】 【図12】

【図12】